모든 언어의 신경망 구축하기

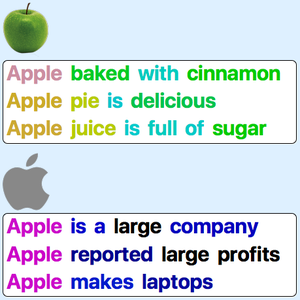

영어로는 많은 경우, 자연어 처리의 첫 단계로 텍스트를 단어로 토큰화하는 것이 효율적입니다. 단어가 의미적인 단위를 나타내어 공백이나 문장 부호에 의해 간단히 구분할 수 있기 때문입니다. 그러나 언어에 따라서는 토큰화를 실행하기 어려운 경우(중국어 등)나, 너무 복잡한 의미적 단위를 생성해 버리는 경우(복합어 등)가 있습니다. 바이트 페어 인코딩(BPE)에 의한 서브워드의 토큰화는 어느 언어에나 적용할 수 있는 효율적인 대안이라고 할 수 있습니다. 이 예는 지정된 언어의 신경망을 작성하는 출발점으로서 매개 변수화된 BPE 매립 모델을 사용하는 방법을 설명합니다.

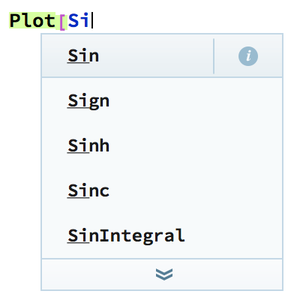

Wolfram Neural Net Repository에서 사용할 수 있는 매개 변수화된 BPE 매립에 대한 정보를 얻을 수 있습니다.

기본이 아닌 매개 변수로 모델을 로드합니다.

매립 층을 문장에 적용하여 매립 벡터열을 반환합니다(각 서브 워드 토큰에 1개의 벡터).

층의 BPE 토큰화 부분을 추출합니다.

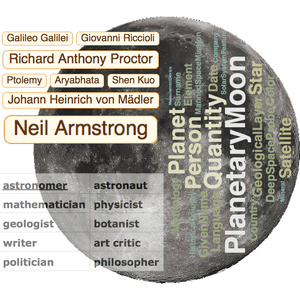

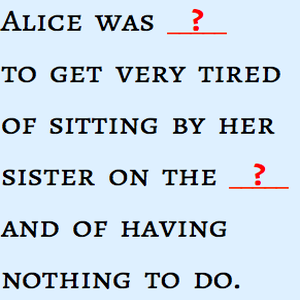

문장의 토큰화를 시각화합니다.

다른 언어의 토큰화를 시각화합니다.

전체 Wolfram 언어 입력 표시하기