Construa redes neurais para qualquer idioma

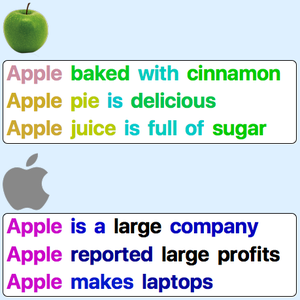

Em inglês, costuma ser eficiente tokenizar o texto em palavras como uma primeira etapa de um aplicativo de processamento de linguagem natural: as palavras são boas unidades semânticas e são facilmente identificadas graças a espaços e pontuação. Em outros idiomas, a tokenização de palavras pode ser mais difícil de ser executada (por exemplo, em chinês) ou cria unidades semânticas complexas demais (por exemplo, em palavras compostas). A tokenização de subpalavras por codificação de pares de bytes (em inglês BPE) é uma alternativa eficiente que pode ser aplicada a qualquer idioma. Este exemplo demonstra como usar um modelo de incorporação BPE parametrizado como ponto de partida para criar uma rede neural para um determinado idioma.

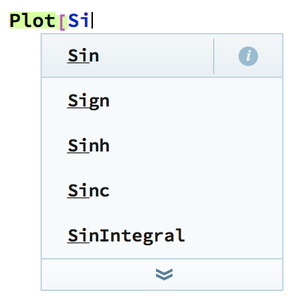

Obtenha informações sobre os agrupamentos BPE parametrizados disponíveis no Wolfram Neural Net Repository.

Carregue um modelo com parâmetros não padrão.

Aplique a camada de incorporação a uma frase para retornar uma sequência de vetores de incorporação (um vetor para cada token de subpalavra).

Extraia a parte de tokenização do BPE da camada.

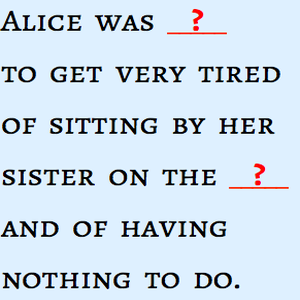

Visualize a tokenização da sentença.

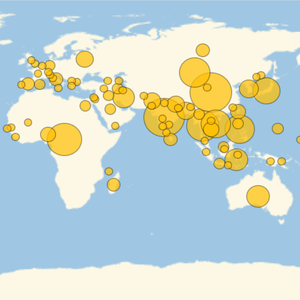

Visualize a tokenização para outros idiomas.