Créez des réseaux neuronaux pour toutes les langues

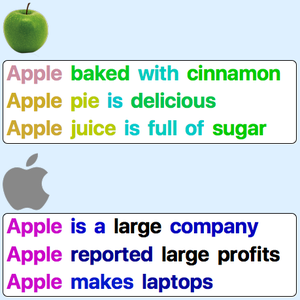

En anglais, il est souvent efficace de tokeniser le texte en mots comme première étape d'une application de traitement du langage naturel : les mots sont de bonnes unités sémantiques, et ils sont facilement identifiables grâce aux espaces et à la ponctuation. Dans d'autres langues, la tokenisation de mots peut être plus difficile à réaliser (par exemple en chinois) ou crée des unités sémantiques trop complexes (par exemple en mots composés). L'encodage par paire d'octets (BPE) est une alternative efficace qui peut être appliquée à n'importe quelle langue. Cet exemple illustre comment utiliser un modèle d'intégration BPE paramétré comme point de départ pour créer un réseau neuronal pour une langue particulière.

Retrouvez des informations sur les BPE paramétrés, disponibles dans le référentiel Wolfram Neural Net Repository.

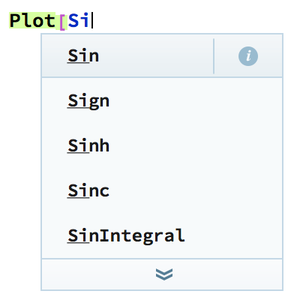

Téléchargez un modèle avec des paramètres autres que ceux par défaut.

Appliquez le couche intégration à une phrase pour renvoyer une séquence de vecteurs d'intégration (un vecteur pour chaque token de sous-mots).

Extrayez la partie BPE de la couche.

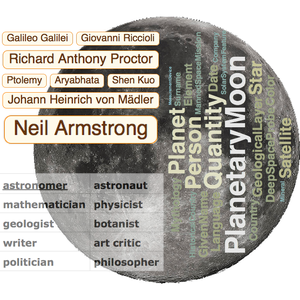

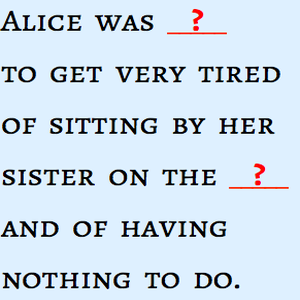

Visualisez la tokenization de la phrase.

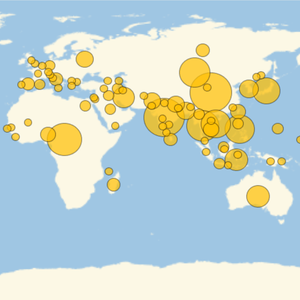

Visualisez la tokenisation pour les autres langues.