Analise dados da Wikipédia

Este exemplo realiza algumas análises de dados sobre o dump (despejo) de banco de dados da Wikipédia em italiano, que, embora não seja tão grande quanto a Wikipédia em inglês, ainda ocupa mais de 13 gigabytes de dados não compactados.

A Wikimedia Foundation oferece dumps de banco de dados da Wikipedia que podem ser baixados livremente seguindo as instruções aqui.

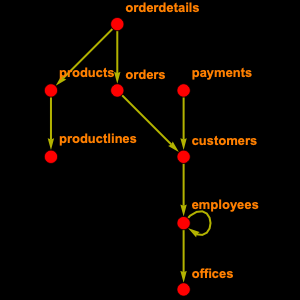

O banco de dados inteiro da Wikipedia contém 56 tabelas. Você não vai precisar de todas elas, então você pode inspecionar seletivamente as que você precisa. Ou seja, "page", que contém informações relacionadas à página, como o título e o comprimento, "revision", que contém uma entrada para cada versão da página e "text", que contém todo o texto do artigo.

A partir disso, você pode construir e registrar um objeto EntityStore.

Veja quantas páginas existem.

Esse número é maior que o número citado na página principal; na verdade, as páginas da Wikipédia estão divididas em namespaces: 0 são artigos, 2 páginas do usuário, 4 páginas de discussão e assim por diante. Então, se você se limitar aos artigos, você obtém o seguinte resultado.

Você pode calcular o tamanho médio de um artigo da Wikipédia.

Ou os 10 maiores artigos.

Curiosamente, a maior página corresponde à história de uma pequena região da Itália.

Outra coisa útil colocar o link de um artigo no seu texto. Infelizmente, isso não é muito fácil, porque um dos princípios dos wikis é que eles acompanham todas as revisões. Por causa disso, você tem que usar o tipo de entidade "revision" para alcançá-lo.

Agora você pode usar isso para encontrar o texto de uma determinada página.

E leia como uma cadeia de caracteres.

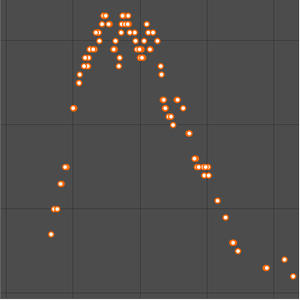

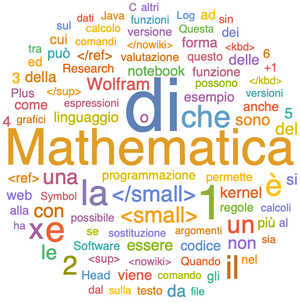

Ou visualize-o como uma nuvem de palavras.