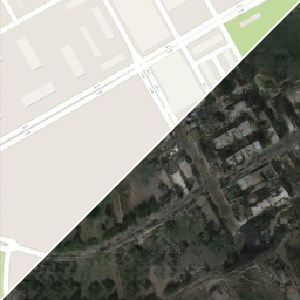

Red neuronal de mapa de sensitividad

Así como los humanos, las redes neuronales tienen la tendencia de hacer trampa o fallar. Por ejemplo, si uno entrena una red con imágenes de animales y si todas las imágenes de "lobo" exhiben nieve en el fondo, entonces la nieve se convierte en un atributo de "lobo". Por lo tanto, la red usa el atributo nieve como un atajo y puede que no aprenda nada acerca de la apariencia del lobo. Como consecuencia, un venado en condiciones nevadas puede ser clasificado erradamente como un lobo.

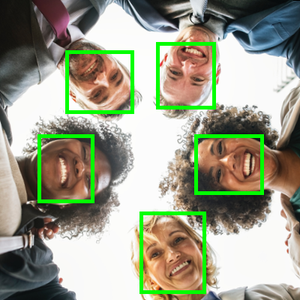

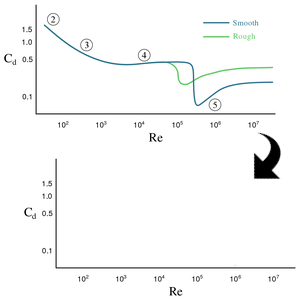

Para entender mejor las clasificaciones erradas y para verificar si una red de clasificación ha aprendido los atributos deseados, el siguiente análisis es de interés.

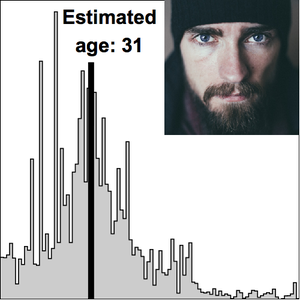

Clasifique una imagen arbitraria y note la probabilidad de clasificación. Luego, cubra partes de la imagen y note si la probabilidad de clasificación aumenta o clasifica. Si la probabilidad baja, el área cubierta contiene atributos que apoyan la clasificación. Si la probabilidad aumenta, el área cubierta contiene atributos que inhiben la clasificación.

Cargue una red neuronal de clasificación de imágenes.

Defina una función que destiña parte de una imagen con un color neutral. El segundo argumento especifica la ubicación del desteñido en coordinadas escalables, y el tercer argumento determina el tamaño de la cubierta como una fracción de tamaño de la imagen.

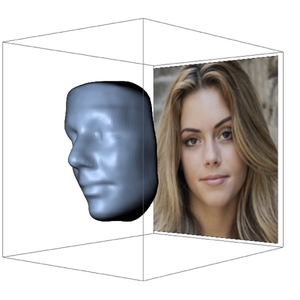

Ahora se puede definir otra función para que cubra sistemáticamente partes de la imagen para mostrar el efecto en la probabilidad de clasificación de la red neuronal específica. El mapa de sensitividad resultante se muestra como brillantez en la imagen de salida.

Genere el mapa de sensitividad de un caballo clasificado como un Morgan con 74% de probabilidad.

Cree un mapa de sensitividad de escala independiente promediando distintos tamaños de cobertura.

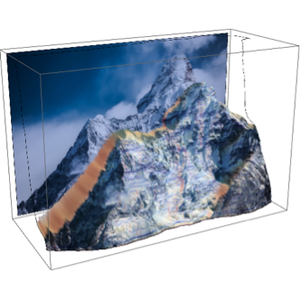

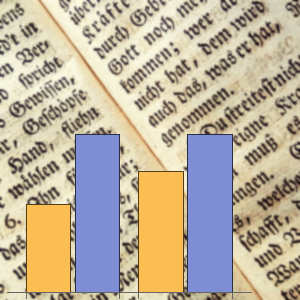

Una clasificación de lobo con una alta probabilidad y un mapa de sensitividad enfocado.

Un mapa de sensitividad de escala independiente del lobo.

Aquí hay un error en la clasificación de un lobo de porcelana con un disco de jabón debido al soporte de la figura.

Una red distinta produce otro error de clasificación al enfocarse en la espalda de la figura, la cual se parece a un dinosaurio.