Representar la semántica de palabras en contexto

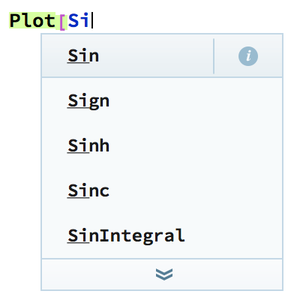

El Repositorio de Redes Neuronales Wolfram contiene muchos modelos para representar palabras por vectores numéricos. Estos vectores semánticos son un elemento clave para resolver aplicaciones de lenguaje. Este ejemplo exhibe un modelo de incrustaciones que toma en cuenta el contexto de cada palabra e ilustra cómo alcanza la desambigüación del sentido de palabras.

La red neuronal ELMo aprendió representaciones contextuales de palabras luego de ser entrenada con cerca de un billón de palabras.

De forma predeterminada, ELMo produce tres vectores por palabra (uno que no es contextual y dos niveles contextuales). La red puede ser fácilmente manipulada para que solo de como salida un vector semántico por cada palabra.

Visualice la salida de la red en un texto (un vector de 1024 dimensiones por cada palabra).

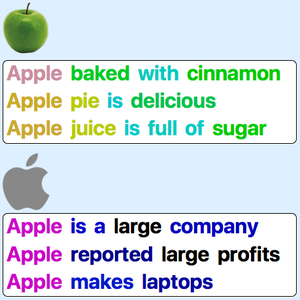

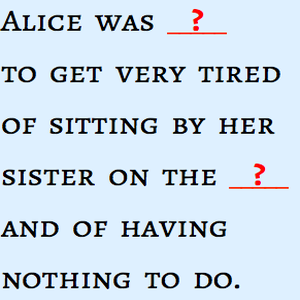

Grafique una representación en 2D de la representación semántica de la palabra "Apple" en diferentes contextos.

Ahora visualice la semántica de la palabra usando colores.

Implemente una reducción de dimensión en 3D a partir de la representación ELMo.

Construya una red que de como salida colores RGB para cada palabra de un texto.

Visualice los colores semánticos de palabras en contextos.