Construya redes neuronales para cualquier idioma

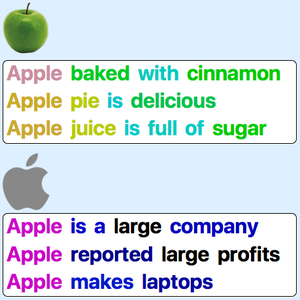

En inglés, usualmente se considera eficiente segmentar texto en palabras como primer paso de una aplicación de procesamiento de lenguaje natural: las palabras son buenas unidades semánticas y pueden ser identificadas fácilmente gracias a los espacios y a la puntuación. En algunos otros idiomas, la segmentación por palabras es una tarea más difícil (ej. en chino) o se crean unidades semánticas muy complejas (ej. en palabras compuestas). La tokenización tde subpalabras de codificación de par de bytes (BPE, en sus siglas en inglés) es una alternativa eficiente que puede ser aplicada a cualquier idioma. Este ejemplo demuestra cómo usar un modelo BPE parametrizado como punto de partida para crear una red neuronal para un idioma dado.

Obtenga información acerca de las incrustaciones BPE parametrizadas disponibles en el Repositorio de Redes Neuronales Wolfram.

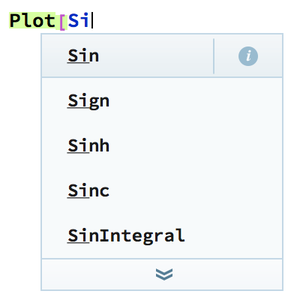

Cargue un modelo con parámentros no predeterminados.

Aplique la capa de incrustación a una oración para regresar una secuencia de vectores de incrustación (un vector para cada token de subpalabra).

Extraiga la parte de tokenización BPE de la capa.

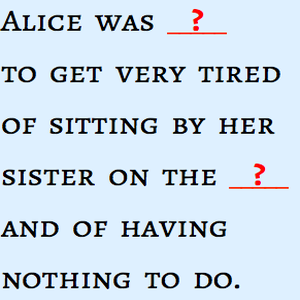

Visualice la tokenización de la oración.

Visualice la tokenización para otros idiomas.