Neuronale Netz für beliebige Sprachen erstellen

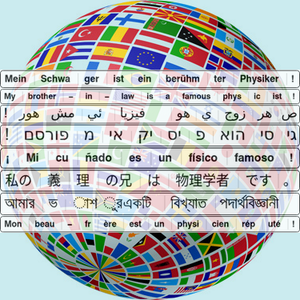

Im Englischen ist es oft effizient, Text als ersten Schritt einer natürlichen Sprachverarbeitungsanwendung in Worte zu tokenisieren: Wörter sind gute semantische Einheiten, und sie sind dank Leerzeichen und Interpunktion leicht zu identifizieren. In einigen anderen Sprachen kann die Wort-Tokenisierung schwieriger sein (z.B. auf Chinesisch) oder zu komplexe semantische Einheiten schaffen (z.B. in zusammengesetzten Wörtern). Die Byte-Paar-Codierung (BPE) von Subwort-Token ist eine effiziente Alternative, die auf jede Sprache angewendet werden kann. Dieses Beispiel zeigt, wie man ein parametrisiertes BPE-Einbettungsmodell als Ausgangspunkt für die Erstellung eines neuronalen Netzes für eine bestimmte Sprache verwendet.

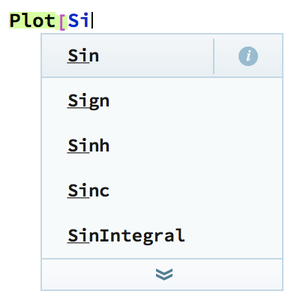

Ermitteln Sie Informationen über die verfügbaren parametrisierten BPE-Embeddings im Wolfram Neural Net Repository.

Laden Sie ein Modell mit nicht voreingestellten Parametern.

Wenden Sie die Einbettungsebene auf einen Satz an, um eine Folge von Einbettungsvektoren zurückzugeben (ein Vektor für jedes Subwort-Token).

Extrahieren Sie den BPE-Tokenisierungsteil der Schicht.

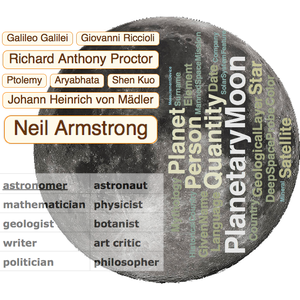

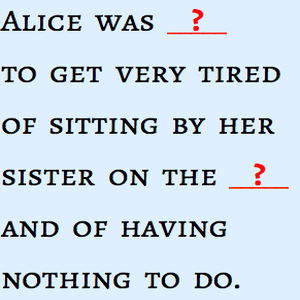

Visualisieren Sie die Tokenisierung des Satzes.

Visualisieren Sie die Tokenisierung für andere Sprachen.