自己正規化ニューラルネットを訓練する

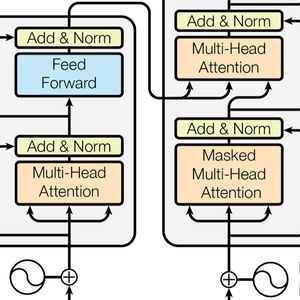

歴史的に見て,数層以上の完全に接続されたニューラルネットワークの訓練は非常に難しかった.深いネットはどれも(たたみ込み層あるいは回帰層のような)重み共有を行なっていた.また,ニューラルネットは,知覚以外のタスクで(ランダムフォーレスト等の)従来の機械学習メソッドに対抗するのに苦労していた.2017年にリリースされた自己正規化ニューラルネットワーク(SNN)は,深く完全に接続されたネットワークの訓練を許す最初のニューラルネットワーク構造であり,(一般にクラスと数の行である)構造化データについて従来のメソッドに対抗できる最初の構造でもある.この例では,そのようなネットの構築と訓練の方法を示す.

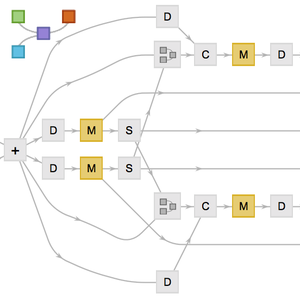

SNNは,非常に単純なクラスのネットワークである.正規化のために,線形層,要素単位の非線形性,"Dropout"の修正版しか使わない.7つの線形層のSNN分類子を構築する.

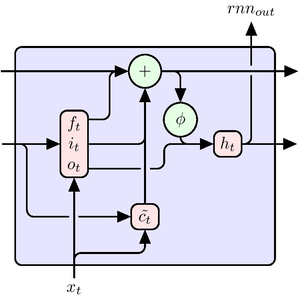

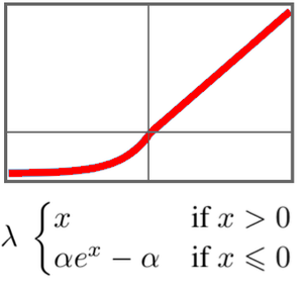

このネットワークの重要な要素は"SELU"(Scaled Exponential Linear Unit)非線形性である. "SELU"非線形性は,データを標準化されたままに保ち,勾配が大きくなりすぎたり小さくなりすぎたりしないようにするという特殊性を持つ.

このネットワークを UCI文字分類タスクで訓練する.

自己正規化ネットは,入力データの平均が0で分散は1であると仮定する.訓練データと検証データを標準化する.

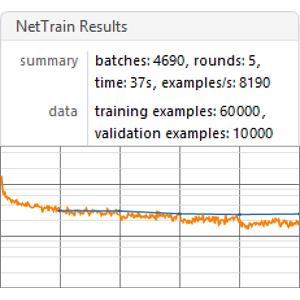

このネットを150ラウンド訓練する.データの5%は検証のために残しておく.

このネットワークを新たな例に使う.

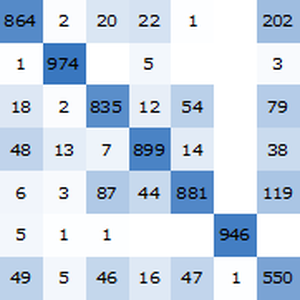

標準化された検証集合に対する訓練済みネットの確度を得る.

自己正規化ネットの確度(約96.4%)は従来の機械学習メソッドに十分対抗できる.