Análisis de datos de Wikipedia

Este ejemplo realiza un análisis de datos en el depósito completo de Wikipedia en italiano, el cual, aunque no es tan grande como el de Wikipedia en inglés, aún toma más de 13 gigabytes de datos sin compresionar.

La Fundación Wikimedia ofrece depósitos de bases de datos de Wikipedia que pueden ser descargados libremente siguiendo las siguientes instrucciones.

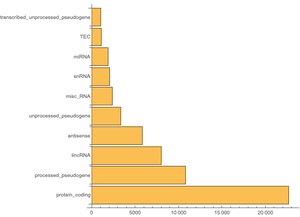

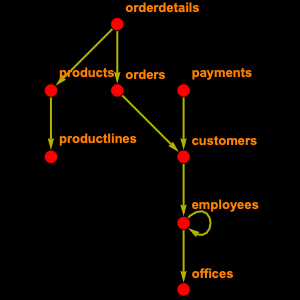

La base de datos completa de Wikipedia contiene 56 tablas. Usted no necesitará todas ellas, así que puede seleccionar solo algunas. Precisamente, "page", que contiene información relacionada con la página, tal como título y longitud, "revision", que contiene una entrada por cada versión de la página y "text", que contiene el texto completo del artículo.

A partir de esto, usted puede construir y registrar un objeto EntityStore.

Vea cuántas páginas hay ahí.

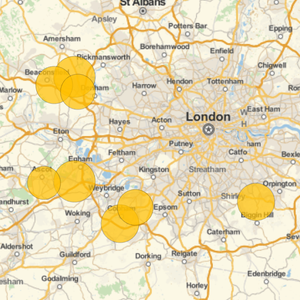

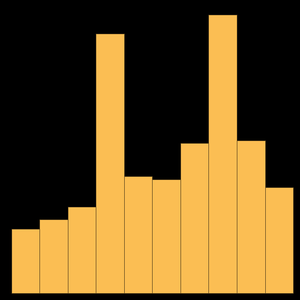

Esto es mayor en comparación al número citado en la página principal; de hecho, las páginas de Wikipedia están divididas en espacios de nombres: 0 son artículos, 2 páginas de usuario, 4 páginas de charlas, etc. Así que si nos restringimos a los artículos para obtener lo siguiente.

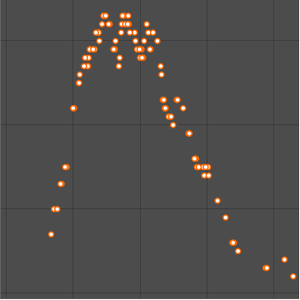

Usted puede calcular la longitud promedio de un artículo de Wikipedia.

O los 10 artículos más largos.

Interesantemente, la página más grande corresponde a la historia de una pequeña región de Italia.

Otro aspecto útil es enlazar un artículo con su texto. Desafortunadamente no es fácil porque uno de los principios de los wikis es poder rastrear todas las revisiones. Debido a esto hay que navegar el tipo de entidad "revision" para lograrlo.

Ahora usted puede usar esto para encontrar el texto de una página en particular.

Y leerlo como una cadena de caracteres.

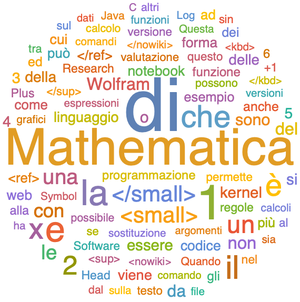

O visualizarlo como una nube de palabras