分析维基百科数据

此范例对意大利维基百科的完整转储执行一些数据分析,虽然没有英语维基百科那么大,但仍然占用超过 13 千兆字节的未压缩数据。

维基媒体基金会提供维基百科的数据库转储,可以按照 此处 的说明免费下载。

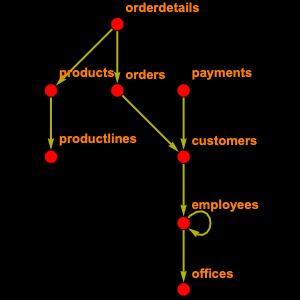

整个维基百科数据库包含 56 个表。您不需要所有这些,因此您可以有选择地检查您需要的那些。即,"page",其包含与页面相关的信息,例如标题和长度,"revision",其具有用于页面和 "text" 的每个版本的条目,其包含文章的整个文本。

从这里你可以构造和注册一个 EntityStore 对象。

查看有多少页面。

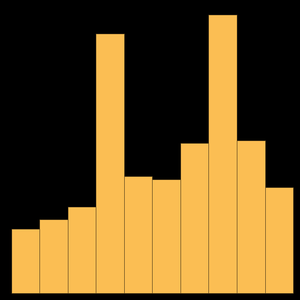

与主页上引用的数字相比,这个数字更高; 事实上,维基百科页面分为名称空间:0 是文章,2 是用户页面,4 是谈话页面,等等。因此,如果您将自己局限于文章,则可获得以下内容。

您可以计算维基百科文章的平均长度。

或者是 10 篇最大的文章。

有趣的是,最大的页面对应于意大利一个小地区的历史。

另一个有用的东西是将文章链接到其文本。不幸的是,这并不容易,因为维基的原则之一是他们跟踪所有修订。因此,您必须通过 "revision" 实体类型才能获取。

现在,您可以使用它来查找特定页面的文本。

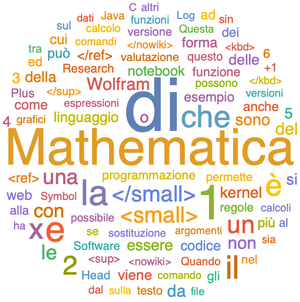

并将其作为字符串读取。

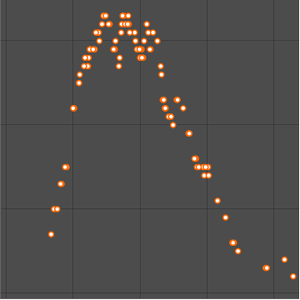

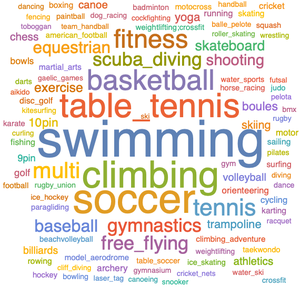

或者将其可视化为文字云。