任意言語のニューラルネットを構築する

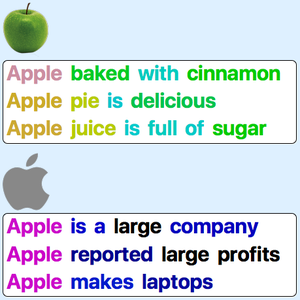

英語では多くの場合,自然言語処理の第1ステップとして,テキストを単語にトークン化することが効率的である.単語が意味的な単位を表し,スペースや句読点によって簡単に見分けられるからである.しかし言語によっては,トークン化が実行しにくい場合(中国語等)や,あまりに複雑な意味的単位を生成してしまう場合(複合語等)がある.バイト対符号化(BPE)によるサブワードのトークン化はどの言語にも適用できる効率的な代替策といえる.この例では指定された言語のニューラルネットを作成する出発点として,パラメータ化されたBPE埋込みモデルを使う方法を説明する.

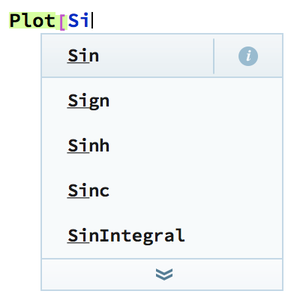

Wolfram Neural Net Repositoryで利用できる,パラメータ化されたBPE埋込みについての情報を取得する.

デフォルトではないパラメータでモデルをロードする.

埋込み層を文に適用して,埋込みベクトル列を返す(各サブワードトークンに1つのベクトル).

層のBPEトークン化の部分を抽出する.

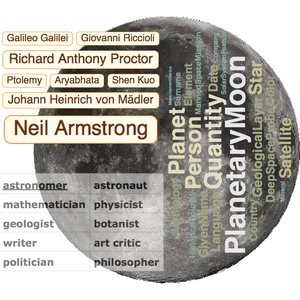

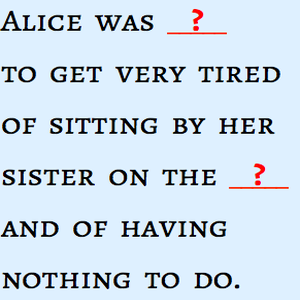

文のトークン化を可視化する.

他の言語のトークン化を可視化する.

完全なWolfram言語入力を表示する